導入:AI活用の「次なるステップ」へ

昨今、生成AI、特に大規模言語モデル(LLM)の活用は、ビジネスシーンにおいて急速に一般化しています。多くの企業がChatGPTや各種AIツールを導入し、業務効率化の第一歩を踏み出しました。

しかし、AI活用の真価は、単なる「ツール導入」の先にあります。リベルクラフトが登壇したウェビナー「LLMは、クラウドか?ローカルか? RAG×AI Ready Dataで探る最適なAI基盤設計」では、AIを「実務レベルで使い込み、その判断軸の精度を上げていく」フェーズへの移行が急務であると警鐘を鳴らしています。

AI活用を成功させるためには、「AI × Data × Algorithm」という3つの要素をいかに最適に組み合わせるかが鍵となります。

- AI: どのLLM(頭脳)を選ぶか?

- Data: どのようなデータ(情報)をどう(AI Readyな状態に)整備して与えるか?

- Algorithm: どのようなアルゴリズム(処理手順)でAIを制御するか?

この記事では、特に「AI(LLMの選定)」と「Data(AI Ready Data化)」に焦点を当て、クラウドとローカル、それぞれの最適なAI基盤設計について、同ウェビナーの内容に基づき深く掘り下げていきます。

1. LLM選定の重要軸:クラウド vs ローカル徹底比較

AI、特に生成AIやLLMは、AIシステム全体における「屋台骨であり頭脳部分」です。この頭脳を「クラウド(API)」で賄うのか、それとも「ローカル(オンプレミス/自社GPU)」で構築するのか。これは、現代のAI戦略における最大の岐路と言えます。

クラウドLLMとローカルLLMのメリット・デメリット

ウェビナーでは、双方の特性を詳細な比較表で整理しました。その要点をまとめます。

判断基準:「コスト」と「セキュリティ」

この比較からわかるように、多くの一般的なユースケース、特に導入初期段階では、導入スピードと性能に優れるクラウドLLMが依然として強力な選択肢です。しかし、特定の条件下ではローカルLLMが「Better(より良い)」あるいは「Must(必須)」になるという点です。その二大要因が「コスト」と「セキュリティ」です。

- コスト: API従量課金は、利用頻度が上がれば上がるほど青天井で増加します。PoC(概念実証)では問題なくても、全社展開した途端に莫大なコストが発生するリスクがあります。ローカルLLMは初期投資こそ必要ですが、一度構築すればランニングコストは(電気代や保守費を除き)実質的に固定化できます。

- セキュリティ: 機密情報、個人情報、研究開発データなど、外部への送信がポリシー上一切許可されないケースは多々あります。この場合、選択肢はローカルLLM一択となります。

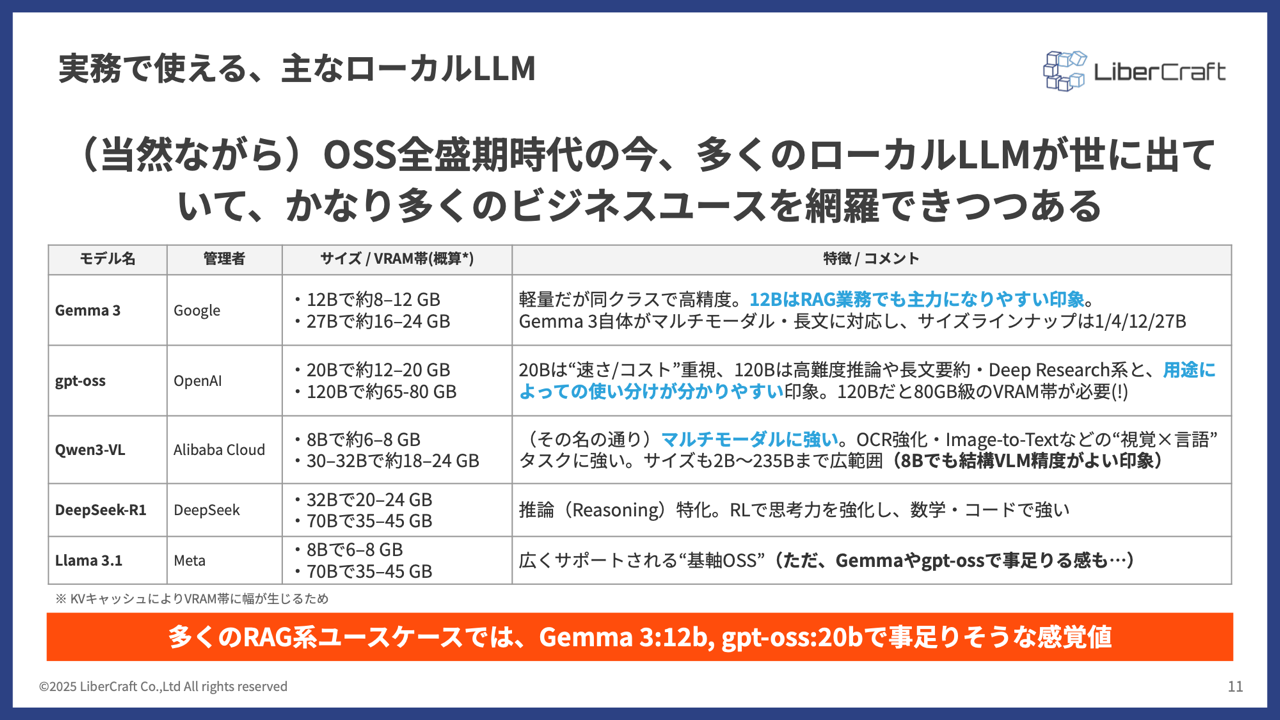

ローカルLLMの現状:OSS(オープンソース)全盛時代の到来

「ローカルLLMは性能が低い」というのは、もはや過去の話です。ウェビナーでは、現在、多くの高性能なOSSモデルが公開されており、ビジネスユースケースの多くをカバーできる「OSS全盛時代」に突入しています。

- Gemma 3 (Google): 12B(120億パラメータ)クラスでも軽量ながら非常に高性能。ラフな感覚値として「Gemma 3: 12B ≒ gpt-oss: 20B」程度であり、速度と性能のバランスが良いと評価されています。

- gpt-oss (OpenAI): 20Bは“速さ/コスト”重視、120Bは高難度推論や⻑文要約‧Deep Research系と、用途に よっての使い分けが分かりやすい印象です。

- Qwen3-VL (Alibaba): 強力なマルチモーダル性能を持ち、OCR(画像からの文字認識)や言語タスク(Reasoning)に強い。後述するVLM(Vision Language Model)の活用で注目されます。

このように、用途に応じて多様な高性能モデルがローカル環境で利用可能になっているのが現状です。

VLM (Vision Language Model) という新たな可能性

特に注目すべきは、Gemma 3やQwen3-VLのようなVLM(Vision Language Model)の登場です。これは、テキストだけでなく画像も理解できるLLMを指します。

例えば、Gemma 3が工事現場の画像を見て「保護具(ヘルメットや安全帯)の着用ルール」を遵守しているか否かを判断するといったユースケースを考えると、LLMの活用がテキストベースのチャットボットや要約に留まらず、画像や図面といった非テキストデータの領域にも拡大していることを示しています。

ローカルLLM導入の壁「GPU」は乗り越えられるか?

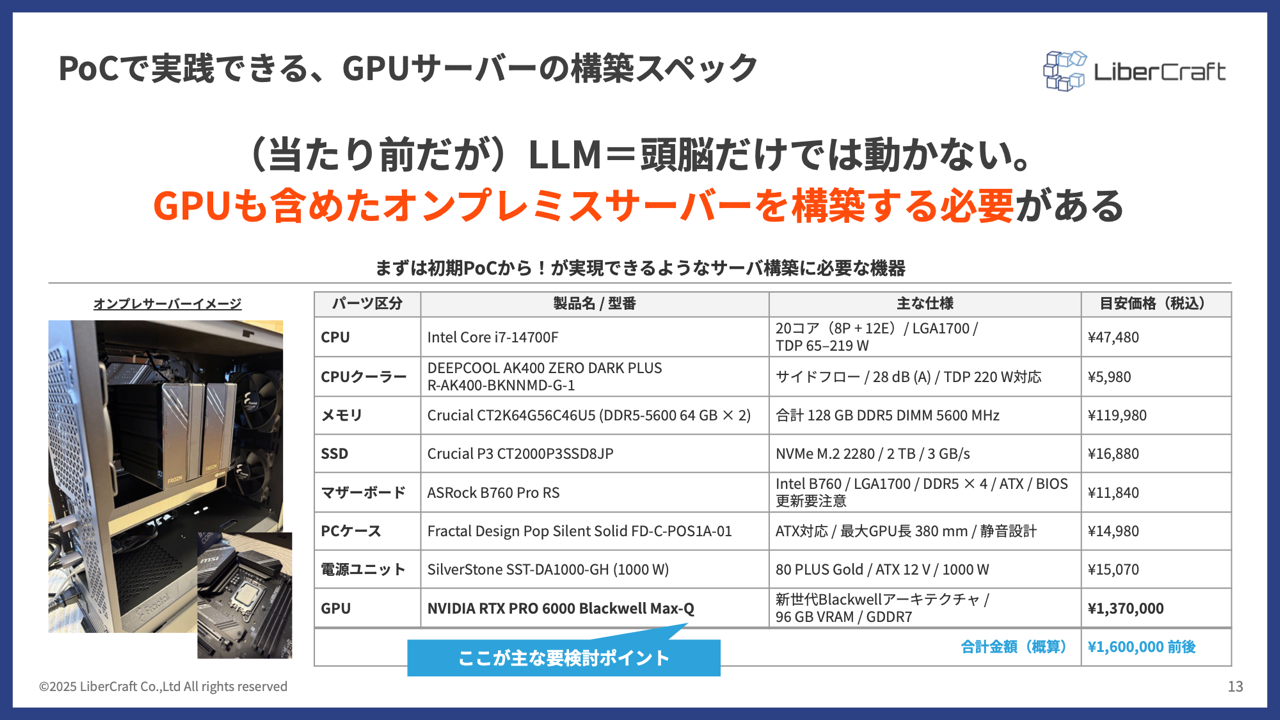

ローカルLLMの最大のハードルは、高価なGPUサーバーが必要という点です。しかし、この認識もアップデートが必要かもしれません。

ウェビナーで紹介したPoC(概念実証)用オンプレミスサーバーの構成例では、CPU、メモリ、SSDなどに加え、GPUとして「NVIDIA RTX PRO 6000 Blackwell(96GB VRAM)」を搭載したスペックで、合計約160万円(税抜)程度という目安感で構築自体はできてしまいます。

もちろんこれはあくまで一例であり、本格運用には更なる投資が必要ですが、「ローカルLLM=数千万円の投資が必須」というわけではなく、PoCレベルであれば現実的なコスト感でスモールスタートが可能であることを示しています。

そして重要なのは、このGPU投資が「LLMを動かすためだけ」ではないという点です。次章で解説する「AI Ready Dataへの構造化」においても、GPUは絶大なメリットをもたらします。

2. 事例Deep Dive:LLM活用の3つの実践的ユースケース

ローカルLLMやVLMが、具体的なビジネス課題をどう解決するのか。ウェビナーで紹介した3つの先進的な事例を詳しく見ていきましょう。

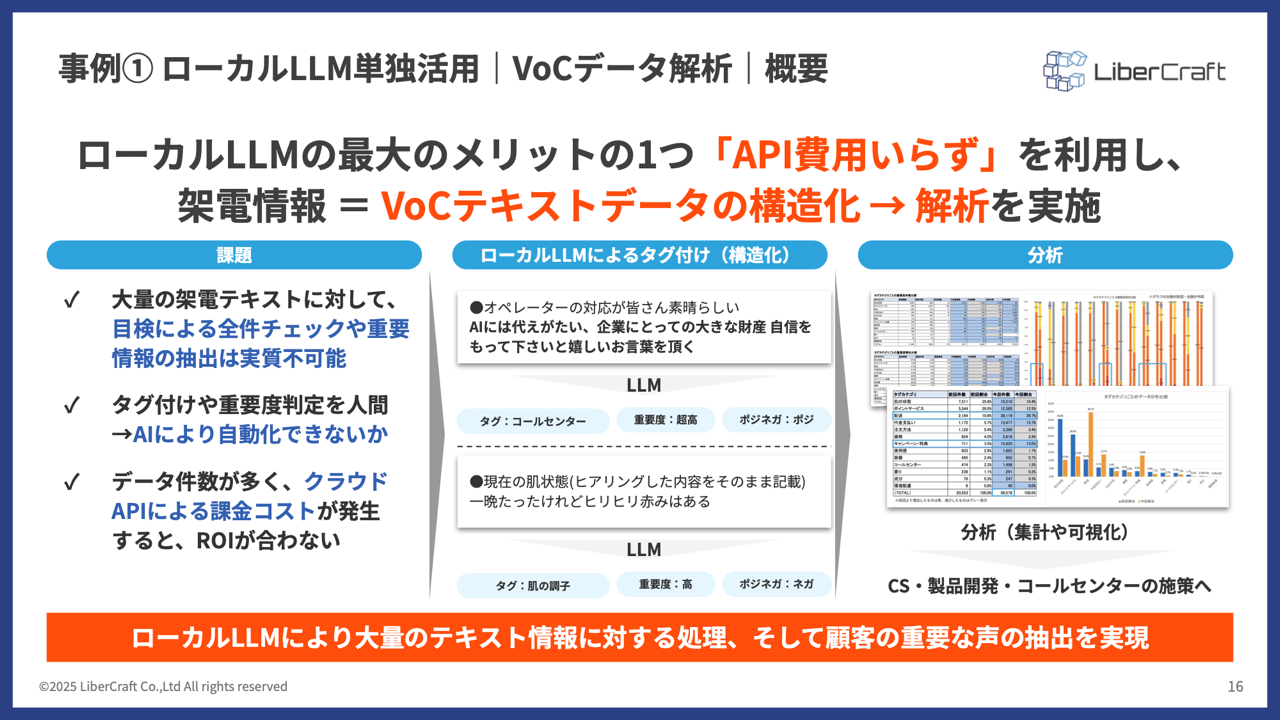

事例1:ローカルLLM単独活用|VoC(顧客の声)データ解析

大量のテキストデータを、コストを気にせず解析したいケースです。

課題:- ある企業では、毎日数千件単位で「顧客の声(VoC)」がテキストデータとして蓄積されていました。

- これを全件目視でチェックし、タグ付けするのは不可能です。

- かといって、クラウドLLMのAPI(例:OpenAI)を使って全件処理すると、月額数万〜数十万円のAPI利用料が発生してしまい、ROI(投資対効果)が合いません。

解決策:- ローカルLLM(「gpt-oss:20b」モデルなどを使用)をオンプレ環境に構築。

- 「API費用いらず」の環境を実現し、大量のVoCデータ(例:「補充品が届かない」「肌にシミができた」など)をローカルLLMに処理させました。

具体的な手法と効果:- LLMが各テキストを読み、「大カテゴリ(例:定期契約)」「中カテゴリ(例:解約)」「小カテゴリ(例:理由)」といった形で自動的にタグ付け(データ構造化)を行います。

- これにより、従来は「ただのテキストの羅列」だったVoCデータが、「どのカテゴリのクレームが多いか」「ポジティブな意見はどこにあるか」を即座に集計・分析できる「AI Ready Data」へと変わりました。

- コストを完全に固定化したことで、AIによる全件自動判定が可能になり、重要な顧客のインサイトを見逃さなくなりました。

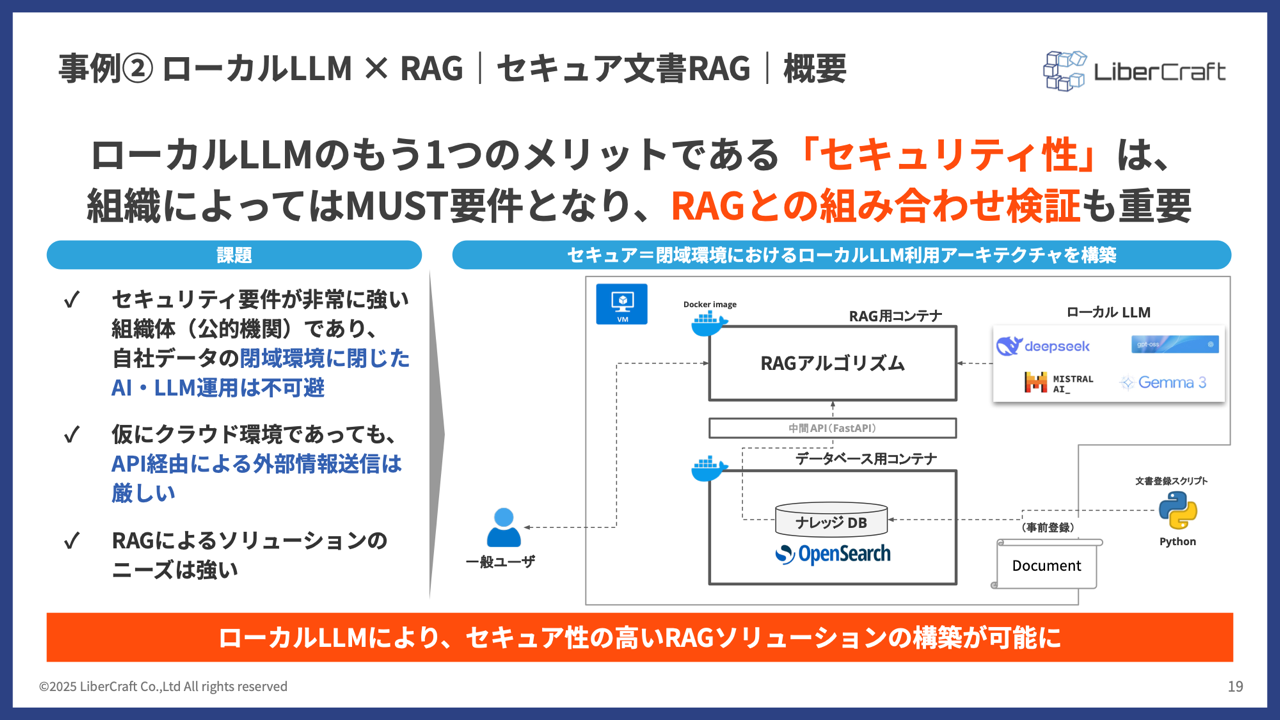

事例2:ローカルLLM × RAG|セキュア文書RAG

機密性を最重要視する組織(例:官公庁、医療、金融、製造業の研究開発部門)でのRAG(Retrieval-Augmented Generation)の事例です。

課題:- 組織内の機密文書(仕様書、研究データ、人事情報など)を対象に、セキュアな環境で対話型AI(RAG)を構築したい。

- クラウドLLMのAPIを利用すると、機密データが外部(ベンダー)に送信されてしまうため、セキュリティポリシー上、絶対に許可できない。

解決策:- 全てのコンポーネントを自社の閉域環境(オンプレミス)内で完結させる「セキュアRAG」を構築。

アーキテクチャ:- LLM: ローカルLLM(Gemma 3, gpt-ossなど)を使用。外部へのAPI通信は一切発生しません。

- データ連携DB: 文書データをベクトル化して格納するデータベース(OpenSearchなど)も、閉域環境内に設置します。

- RAGアルゴリズム: ユーザーの質問を受け取り、DBに検索をかけ、取得した文書と質問をローカルLLMに渡すアプリケーションも、全て内部で動作します。

- これにより、データの生成から検索、回答生成までの全プロセスが外部に漏れない、鉄壁のセキュリティが実現します。

RAG 高度化のヒント:- ウェビナーでは、単純なRAGでは精度が出ない点も指摘されました。

- 精度向上の鍵は「Retrieval(検索)」と「Rerank(再ランキング)」の分離です。

- 単にベクトル検索(類似度検索)するだけでなく、全文検索を組み合わせたり、文書の「チャンク(分割単位)」を工夫したり(例:周辺のチャンクも一緒に参照する)することが重要です。

- さらに、「Rerankモデル」という別の小型AIモデルを導入し、検索結果の「順序」を最適化することで、LLMはより精度の高い回答を生成できます。

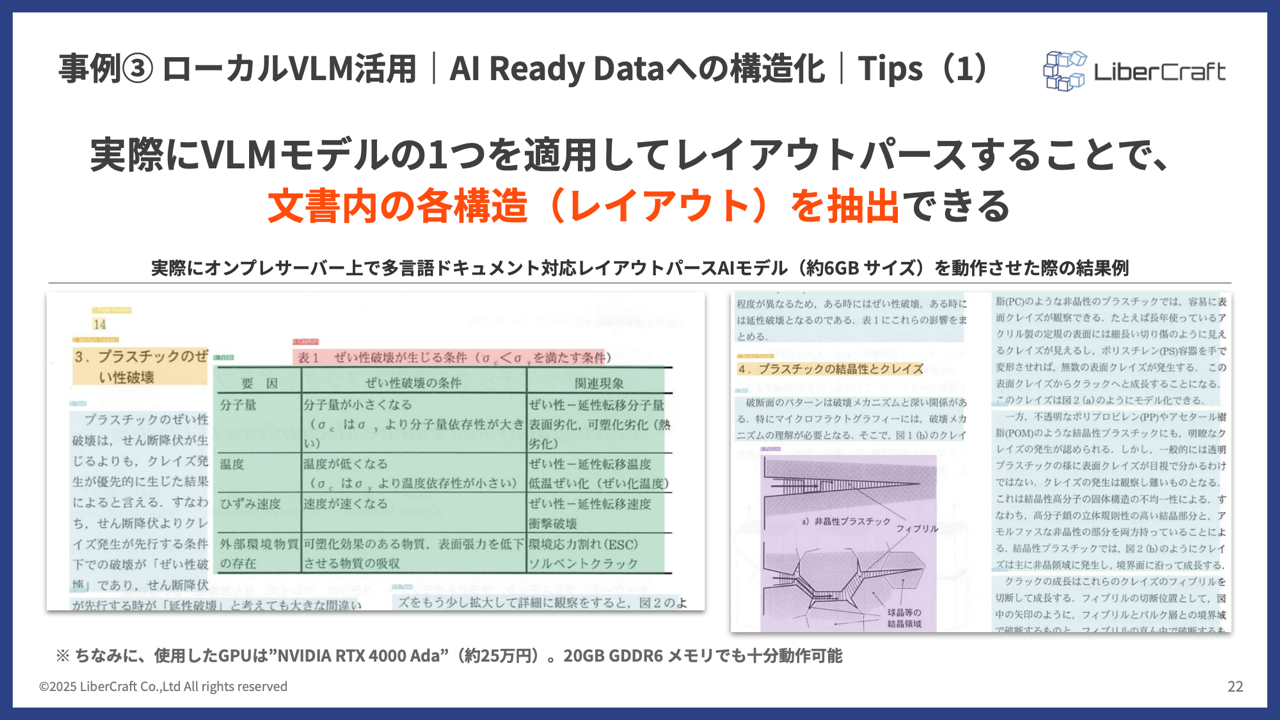

事例3:ローカルVLM活用|AI Ready Dataへの構造化

AI活用の最大のボトルネックである「データ整備」を、AI(VLM)で解決する最先端の事例です。

課題:- AIに学習させたいデータが、綺麗なテキストやExcelデータであるとは限りません。

- 実務では、PDF内の複雑な表、手書き文字の混じった回路図、技術文書内のグラフ、顕微鏡写真など、非構造的なデータが溢れています。

- これらを人間が手作業で「AI Ready Data(AIが理解できる構造化データ)」に整備するのは膨大な工数がかかり、AI活用のボトルネックとなっています。

解決策:- ローカルVLM(Vision Language Model)をオンプレGPU上で活用し、これらの非構造データの「構造化」を自動化します。

Tips (1) :VLMによる「レイアウトパーサー」- VLMは、文書画像を見るだけで、それが「テキストブロック」なのか、「表」なのか、「図」なのかを人間のように理解し、そのレイアウト(配置)情報を抽出できます。

- 従来のOCR(光学的文字認識)では困難だった、二段組の論文や複雑なレイアウトの仕様書からでも、正確にテキストや表のデータを構造化して抜き出すことが可能です。

- 驚くべきことに、このレイアウトパーサー機能を持つVLM(約6GB)は、約25万円程度のGPU(NVIDIA RTX 4000 Ada)でも十分に動作可能であり、導入ハードルは非常に低いとされています。

Tips (2) :VLMによる「キャプショニング」- さらにVLMは、レイアウトの抽出に留まらず、画像の内容自体を理解できます。

- 例えば、製造業における「クラック(ひび割れ)の顕微鏡写真」をVLM(「Qwen3-VL:8b」を使用)に見せると、「(a) 白い線がクラックを示しており、表面の不均一さが確認できる…」といった詳細なキャプション(説明文)を自動生成します。

- この生成された「キャプション(テキスト)」をRAGの検索対象に含めることで、従来は検索不可能だった「画像の内容」に基づいた検索(例:「表面が不均一なクラックの写真を探して」)が可能になります。

3. 実践・実装に向けて:スモールスタート・クイックウィン

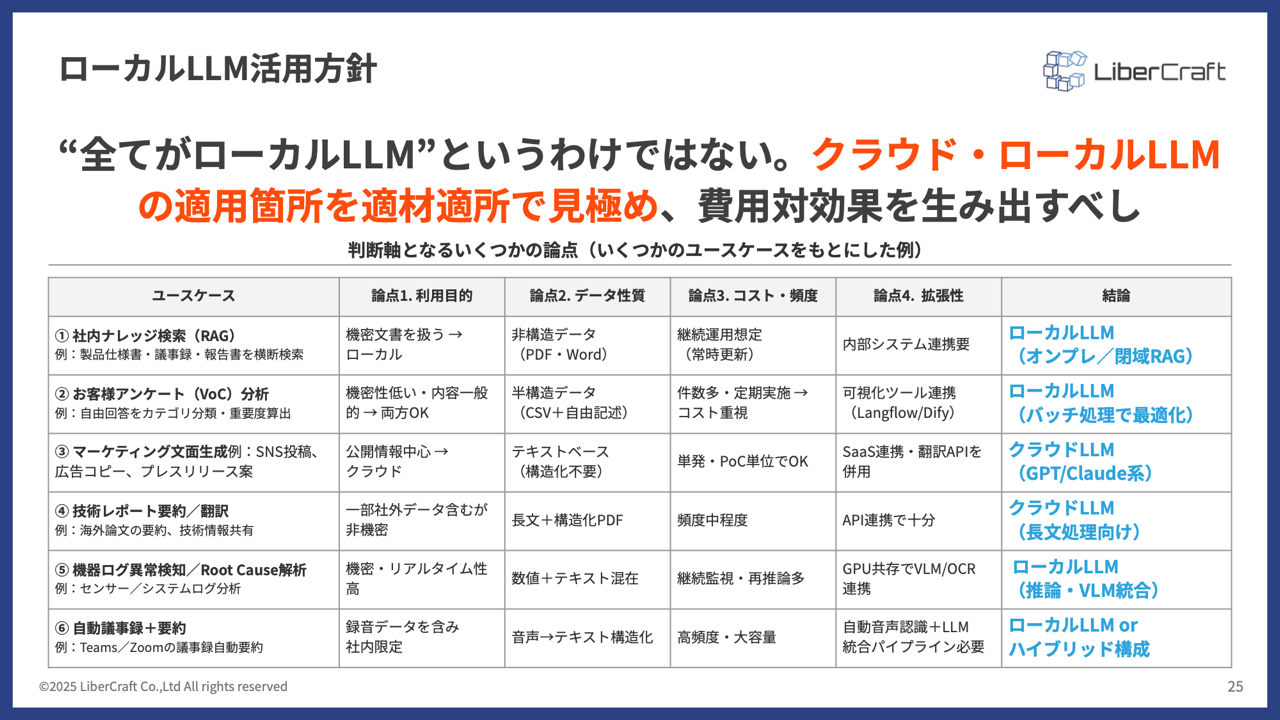

これらの先進的な事例を見て、「うちでもローカルLLMを導入すべきか?」と考え始めた方も多いでしょう。しかし、ウェビナーでは「すべてをローカルLLMで、というわけではない」と強調しました。

ローカルLLM活用の非公式ロードマップ:適材適所の見極め

重要なのは、自社の「ユースケース(課題)」を起点に、クラウドとローカルの最適なバランスを見つける「適材適所」の視点です。

- 判断軸1(利用目的): 機密性(例:社内文書)か、公開情報(例:Web)か。

- 判断軸2(データ特性): テキストのみか、PDF・図表・画像(マルチモーダル)を含むか。

- 判断軸3(コスト・頻度): 利用頻度は低いか、高頻度(例:常時実行)か。

- 判断軸4(拡張性): 内部システム連携がメインか、外部SaaS・API連携が重要か。

これらの軸の組み合わせによって、最適なアーキテクチャは変わります。

- ローカルLLM(閉域RAG): 機密性が高く、コストを抑えたい、内部連携が主。

- クラウドLLM(GPT系): 公開情報が主、利用頻度が低い、最新モデルが使いたい、外部連携が主。

- ローカルLLM(VLM統合): 機密性が高く、図表や画像データを構造化したい。

- ハイブリッド構成: 上記の特性を柔軟に組み合わせる。

自社の課題がどこに当てはまるかを冷静に分析することが、最適なAI基盤設計の第一歩となります。

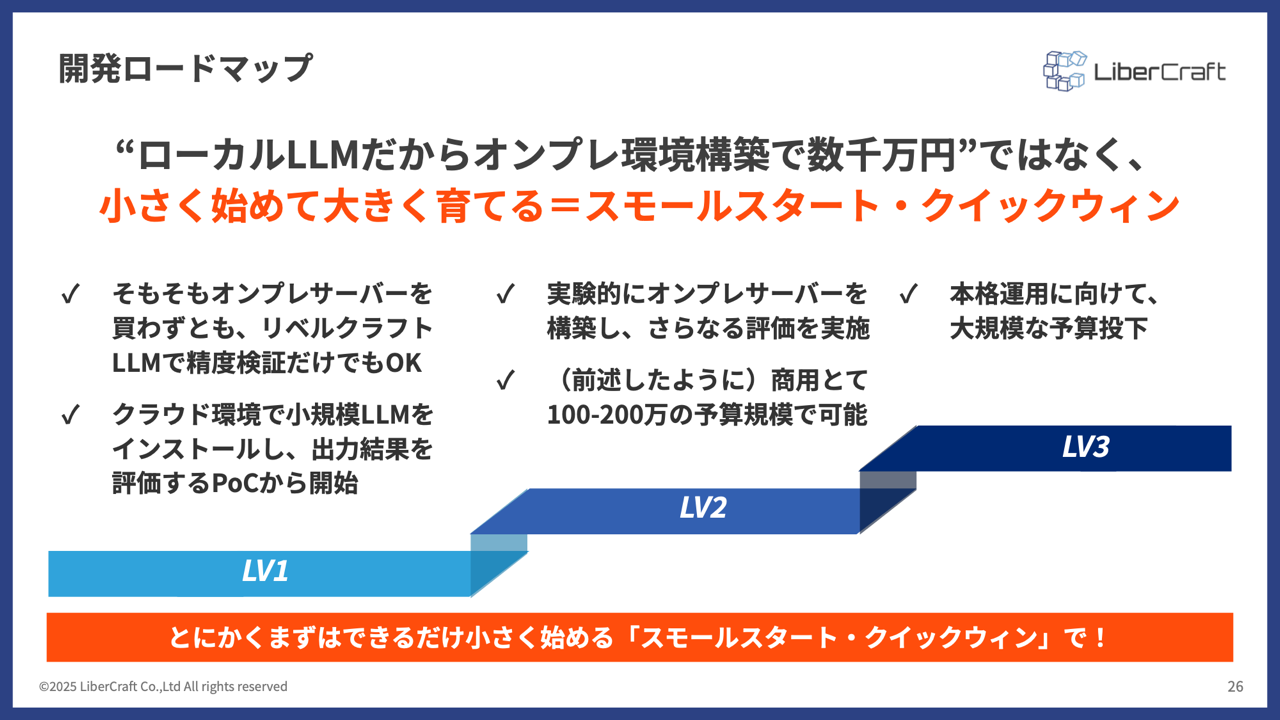

開発ロードマップ:「小さく始めて大きく育てる」

ローカルLLMの導入検討は、いきなり数千万円のサーバー構築から始めるものではありません。リベルクラフトでは、「スモールスタート・クイックウィン」というアプローチを推奨しています。

- LV1: 評価とPoC

- まずは、既存のクラウド環境や小規模なローカルLLM(場合によっては既存サーバーのリソース)でPoCを実施します。

- 「そもそもオンプレサーバーを買う価値があるか?」の初期評価を行います。

- LV2: 実験的構築とさらなる評価

- 価値が見込めると判断できれば、ここで初めて実験的なオンプレサーバー(前述の160万円程度の構成+構築費用など)を準備します。

- より詳細な評価や、複数のユースケースでのPoCを(コストを気にせず)実施します。

- LV3: 本格運用と大規模予算

- PoCで明確な成果とROIが見えた段階で、初めて本格運用に向けた大規模な予算投下とシステム構築に進みます。

このステップを踏むことで、「ローカルLLMは高すぎる」という初期の思い込みを排除し、リスクを最小限に抑えながら着実にAI活用のレベルアップを図ることが可能になります。

まとめ:AI導入がゴールではない。その先の「業務成長」のために

今回のウェビナーで提示された知見は、AI活用の現実的なロードマップを明確に示してくれました。最後に、重要なポイントを再確認します。

- 「AI × Data × Algorithm」の判断軸を意識する

AI活用は「ツール導入」で終わりではありません。3つの要素の解像度を上げ、精度を向上させ続ける意識が不可欠です。 - セキュリティ・コストの軸で「ローカルLLM」を検討する

クラウドが万能ではない現代において、機密性やコスト(特に高頻度利用)が課題となる場合、ローカルLLMは極めて強力な選択肢となります。 - 「AI Ready Data化」こそがローカルGPUのキラーユース

ローカルLLM/VLMの真価は、回答生成だけでなく、図表や画像を含む非構造化データを「AI Ready Data」に構造化するプロセスにもあります。この「データ整備」にこそ、GPU投資の価値があります。 - 「適材適所」で費用対効果を狙う

ローカル単独、クラウド単独、あるいはハイブリッド。自社の課題に最適なアーキテクチャを選択することが、最も費用対効果を高めます。 - 「スモールスタート・クイックウィン」で始める

いきなり大規模投資を目指すのではなく、まずはPoCから。小さく始めて素早く成果を出し、その価値を証明しながら大きく育てていく。これが、不確実性の高いAIプロジェクトを成功に導く鍵です。

ウェビナーの最後でも述べたように、AI導入そのものがゴールなのではありません。

その真の目的は、「AI活用・DX推進による業務改善や事業成長」にあるはずです。

クラウドか、ローカルか。その選択は、この最終ゴールから逆算して、最も合理的かつセキュアな道筋を探る戦略的な一歩に他なりません。

また、以下のホワイトペーパーページでは、本内容にの資料を公開しておりますので、より興味のある方は、ぜひご覧ください。